Qualquer um que já tenha trabalhado com pesquisa quantitativa e, especialmente, com pesquisa experimental (ou pelo menos tenha feito um curso geral de estatística) já se deparou com o tal “valor-p”. Normalmente, ele é apresentado como a medida do que os estatísticos denominam “significância estatística” e é empregado dentro do que se convencionou denominar “Testes de Significância de Hipótese de Nulidade”.

Apesar de extremante disseminados, a ideia de “valor-p” e o próprio conceito de “significância estatística” são muito mal compreendidos pelos não estatísticos. De fato, acredito que poucas pessoas fora do campo conseguiriam (de cabeça) definir o que é um valor-p e muito menos explicar, em poucas palavras, o conceito de significância estatística. Eu não sou diferente [1]. Por favor, não entenda isso do jeito errado. O valor-p não é um conceito ambíguo ou mesmo vago. Ele tem uma definição bem precisa, na verdade. O problema é que essa definição não é só bastante críptica, como parece violar algumas de nossas intuições. Creio, inclusive, que venham daí boa parte dos problemas com essa medida e com o conceito associado de significância estatística.

O que ocorre é que existe um conflito entre a maneira como a principal abordagem à estatística (‘frequencista’ ou ‘frequencialista’) encara o processo de inferência e a forma intuitiva que nós, seres humanos, quase sempre recaímos ao pensar e conversar sobre o assunto, ou seja, sobre como tirar conclusões a partir da análise de nossos dados e dos testes estatísticos que realizamos neles.

Mas, afinal de contas, o que é o valor-p?

Acredito que a forma mais simples de explicar o que é o valor-p, sem incorrer em muitos erros, seria simplesmente dizer que ele é uma medida da incerteza associada ao processo de inferência. Mas isso não nos diz muito, não é? Porém, ao avançarmos um pouco mais nas definições já surgem as primeiras complicações. A primeira tentação é pensar que os valores-p nos dão um indicativo da probabilidade de nossos resultados. Embora não haja de fato como negar que isso é parcialmente verdade, o problema é exatamente compreender que tipo de probabilidade é essa. A segunda tentação é avançar por essa linha de raciocínio e afirmar que os valores-p nos dariam a probabilidade de estarmos errados ou de que a hipótese em questão seja verdadeira. Não, ele não nos diz nada disso, pelo menos não diretamente. O mais importante é compreender que o valor-p não é uma probabilidade simples de um evento em particular. Ele é uma probabilidade cumulativa, mas não apenas isso. Calcular um valor-p depende de assumirmos de antemão que uma dada hipótese é verdadeira. Portanto, o valor-p é uma probabilidade cumulativa condicional. A terceira tentação é assumir, ingenuamente, que a hipótese em questão (sob a presunção da qual o valor-p é calculado) seja a hipótese substantiva. Raramente esse é o caso, se é que é alguma vez. Esse é outro grande problema: A hipótese que é realmente testada e que precisa ser assumida previamente apara calcular-se o tal valor não é geralmente a hipótese de maior interessante.

Agora podemos dar uma definição mais direta do que é o valor-p, como a disponível no artigo de Dennis Robert no site Medium:

O valor p é a probabilidade de se obter um resultado pelo menos tão extremo quanto o resultado atual obtido quando a hipótese de nulidade for verdadeira.

Observe que o primeiro ponto que chama a atenção é fato de que a probabilidade em questão não referir-se só aos valores obtidos em um estudo, mas a ele e a outros eventuais valores hipotéticos. O segundo e talvez mais importante é que o valor-p diz respeito somente a hipótese de nulidade. Como Dennis Robert explica em seu artigo para o Medium:

O valor-p não indica nada sobre o resultado do teste ser verdadeiro (ou falso). A existência de valor-p é válida apenas sob a suposição de que a hipótese de nulidade é verdadeira e todas as suas definições e interpretações só podem ser definidas dentro dessa suposição. […]

Prob (observação dos dados | hipótese) NÃO é igual a Prob (hipótese | observação dos dados).

De acordo com o David Colquhoun, um eminente especialista em bioestatística, confundir essas duas probabilidades bastante diferentes é a principal razão que levaria os valores-p a serem tão frequentemente mal interpretados. Esse erro (ou falácia) é conhecido como “erro da condicional transposta”. Como ele explica:

Mesmo fontes bastante respeitáveis dirão que o valor-p é a probabilidade de que suas observações ocorreram por acaso. E isso está totalmente errado.

Mas vamos tentar compreende melhor essa questão.

Normalmente, o que a maioria dos pesquisadores gostariam de saber é a probabilidade da hipótese de interesse partindo do fato que obtivemos certos dados, o que poderia ser representados como Prob (hipótese | observação dos dados) e não Prob (observação dos dados | hipótese), nem mesmo a Prob (observação dos dados | hipótese de nulidade) ou muito mesmo ainda a Prob (observação dos dados ≥ aos efetivamente observados| hipótese de nulidade), que é o que de fato o valor-p fornece.

Isto é, para calcular o valor-p é preciso primeiro postular que a hipótese de nulidade é verdadeira e tudo decorre daí. Mas veja que o valor-p, nem ao menos, nos dá a probabilidade da hipótese de nulidade Prob (hipótese de nulidade) e nem ao menos a Prob (hipótese de nulidade | observação de dados).

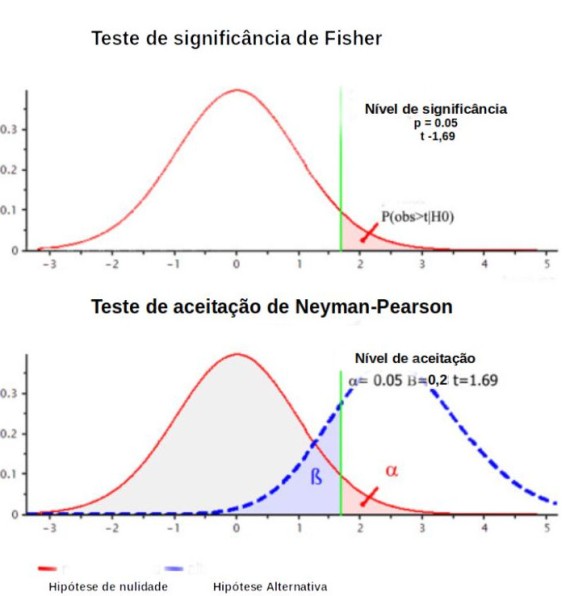

Adaptado de User:Repapetilto @ Wikipedia & User:Chen-Pan Liao @ Wikipedia https://commons.wikimedia.org/wiki/File:P-value_in_statistical_significance_testing.svg#file

Tudo isso nos leva a outra questão:

Afinal, o que é a Hipótese de Nulidade?

A ‘Hipótese de Nulidade’ é simplesmente a hipótese a ser nulificada – isto é, a hipótese que buscamos rejeitar. Normalmente, embora esse não tenha que ser sempre o caso, ela é uma ‘Hipótese Nula’, ou seja, uma hipótese de ‘não diferenças’ ou de ‘não efeito’. Alguns manuais e livros de divulgação enquadram esse tipo de abordagem como uma aplicação da ideia Popperiana de falsificação de hipóteses. Todavia, não é preciso conhecer muito a obra de Popper para perceber que o tipo de hipótese audaciosa que o filósofo Austríaco tinha em mente a ser falsificada em nada se assemelha a maioria das hipóteses de nulidade, especialmente as ‘nulas’.

Para compreender melhor o uso desses testes, precisamos voltar um pouco na história. O cálculo do valor-p foi originalmente proposto pelo eminente estatístico Ronald A. Fisher. Para ele, pelo menos inicialmente, o valor-p servia apenas para ajudá-lo a decidir informalmente se valeria a pena investigar mais pormenorizadamente um conjunto de dados através de outros experimentos, sendo

o ponto de corte, uma escolha conveniente do pesquisador, mas totalmente arbitrária. Mais tarde, o valor-p passou a funcionar como uma medida da força da evidência contra a hipótese de nulidade [2]m, mas jamais foi um critério para se concluir pela realidade de efeito ou fenômeno. Outro ponto importante é que, além desse caráter arbitrário, todo esse edifício inferencial depende de ter sido escolhida a hipótese de nulidade mais adequada [3] e de todo cuidado em termos do processo de amostragem e experimentação, essencial para termos confiança em qualquer conclusão.

Mais tarde, dois outros estatísticos, Jerzy Neyman e Egon Pearson, resolveram dar sua própria contribuição aos métodos de inferência estatística e ofereceram um conjunto de procedimentos para que os pesquisadores a longo prazo (e não em casos individuais) pudessem garantir que seus resultados mantivessem os chamados ‘erros do tipo I’ (‘falsos positivos’) e os ‘erros do tipo II’ (‘falsos negativos’) sob controle. Esse tipo de salvaguarda é importante porque normalmente em qualquer pesquisa queremos evitar não somente obtermos um resultado ‘falso positivo’ (isto é, não queremos obter um resultado positivo quando não há nenhum efeito ou diferença subjacente real), como também não queremos obter um resultado ‘falso negativo’ (isto é, não queremos obter um resultado negativo quando de fato há um efeito ou diferença subjacente real). Como normalmente nossa capacidade de detectar efeitos de certos tamanhos tem relação com o tamanho da amostra, eles propuseram um compromisso entre os dois tipos de erro.

O procedimento Neyman-Pearson envolve diferenciar duas hipóteses, a chamada ‘hipótese principal’ (geralmente chamada de HM ou H0) [2] e a ‘hipótese alternativa’ (às vezes Ha, H1 ou H’). Como explica Jose D. Perezgonzalez, a hipótese alternativa mais simples representaria uma outra população que estaria localizada (estatisticamente falando) ao lado da população da hipótese principal em um mesmo continuum de valores, diferindo-se da primeira população em algum nível que seria equivalente ao ‘tamanho do efeito’.

A partir daí os pesquisadores especificam um valor chamado α (geralmente algo como 5% ou 1%, que deverá ser contrastado ao valor-p) e um valor β (normalmente entre 10% e 20%, relacionado a chamada ‘potência estatística’) de modo a manter os dois erros (tipo I e tipo II) sob controle ao longo de muitos estudos, de preferência em testes padronizados. Diferentemente de Fisher, além de levar em conta uma hipótese alternativa na construção do teste de modo explícito, Neyman e Pearson trazem para frente do processo de planejamento dos estudos, esse novo conceito, a potência estatística, que é a capacidade de detecção de efeitos de certos tamanhos dado um tamanho de amostra.

A potência estatística depende do tipo de teste selecionado, do tamanho do efeito esperado (quanto maior o efeito maior a potência), bem como dos valores α (quanto menor o α menor a potência) e β (menores valores de β aumentam a potência) [3]. Uma vez definidos todos esses valores, o que se faz é calcular o valor-p e, caso ele seja igual ou menor ao α (isto é, caso ele esteja dentro área crítica de rejeição), considera-se apropriado rejeitar a HM e, por conseguinte, aceitar a Ha.

É importante compreender que, enquanto a abordagem de Fisher é a posteriori e mais relaxada (focada nos dados presentes), a estratégia de Neyman e Pearson é a priori e, além de mais criteriosa, tem o objetivo de controlar os erros do tipo I e II a longo prazo, sendo orientada a procedimentos e testes repetidos várias vezes e não aos dados particulares de cada experimento. Alguns autores sugerem que o modelo de Fisher seria mais adequado para estudos exploratórios e o de Neyman e Pearson para estudos de validação com objetivos bem específicos (e de preferência com replicatas exatas) ou mais provavelmente para o controle de qualidade em ambientes industriais. Mas é bom lembrar que em todos os casos, para as conclusões e decisões serem válidas, sempre é pressuposto o emprego de técnicas de amostragem (ou alocação de intervenções) aleatória corretas, além da presença de todas as salvaguardas experimentais, o que, infelizmente, muitas vezes não acontece na prática.

Logo acima, podemos observar (na figura retirada e adaptada de Cyril Pernet), uma ilustração da diferença entre os procedimentos de Fisher e Neyman-Pearson. Segundo a descrição dos autores, a figura foi preparada com o software G-power para um teste t unilateral para uma amostra de 32 indivíduos, um tamanho de efeito de 0,45 e taxas de erro α de 5% e β de 20%.

Logo acima, podemos observar (na figura retirada e adaptada de Cyril Pernet), uma ilustração da diferença entre os procedimentos de Fisher e Neyman-Pearson. Segundo a descrição dos autores, a figura foi preparada com o software G-power para um teste t unilateral para uma amostra de 32 indivíduos, um tamanho de efeito de 0,45 e taxas de erro α de 5% e β de 20%.

Note que no procedimento de Fisher, apenas a hipótese de nulidade é apresentada e o valor-p observado (aqui p = 0,05) é comparado a um nível de significância arbitrário, caso menor ou igual a este valor pode-se usá-lo como evidência contra H0. Já no procedimento de Neyman-Pearson, as hipóteses de nulidade e alternativa são especificadas de maneira explícita juntamente com um nível de aceitação de modo a priori. Se o valor estatístico observado estiver dentro da região crítica, rejeita-se H0 e não se leva em conta o valor-p específico.

O que observamos hoje em dia na prática científica mais corriqueira é uma mistura entre a estratégia de Fisher e o procedimento de Neyman e Pearson. Nessa estranha amálgama, os resultados do teste estatístico são empregados como indicativo de que um experimento ou estudo específico estaria ou não correto e o valor-p é tido como uma medida de quão estatisticamente significativos os resultados seriam e, portanto, do quão mais confiáveis seria essa conclusão. Esse tipo de utilização já seria bastante problemática, mas talvez menos lesivas, caso outras medidas fossem tomadas – como caso estimativas dos tamanhos dos efeitos fossem informadas e sempre fosse enfatizado a necessidade de realizar estudos de replicação independentes e com cálculo prévio da potência estatística. Porém, muitas vezes, esse tipo de abordagem é empregada como critério para se determinar se um estudo deveria ser encaminhado ou não para a publicação ou, pior, editores e revisores de periódicos científico podem utilizá-lo para decidir se aceitam ou não um artigo para ser publicado, criando toda a sorte de vieses e maus hábitos entre pesquisadores, revisores e editores de revistas científicas.

Vamos tentar compreender toda essa história um pouco melhor com um exemplo. Suponha que tivéssemos um conjunto de dados relativos a um teste de um fármaco qualquer. Por exemplo, imagine que uma equipe de pesquisadores clínicos realizou um experimento bem controlado com cem indivíduos que tinham todos uma determinada condição clínica (pressão alta, por exemplo), dividindo-os em dois grupos de cinquenta indivíduos cada.

Em cinquenta desses indivíduos, (o primeiro grupo) foi administrado um fármaco que, em testes preliminares (in vitro, em células de cultura, in vivo, em animais de laboratório e, em alguns estudos não controlados em seres humanos), haviam produzido resultados animadores. Nos cinquenta indivíduos restantes foi administrado um placebo – isto é, a essas pessoas foi dado uma substância virtualmente idêntica a administrada no outro grupo (mesma via de administração, mesmos excipientes, mesmo veículo, mesma aparência etc), com a única diferença sendo o fato de que nesta preparação não havia a substância ativa, que é exatamente o que os cientistas acreditam fazer efeito.

O primeiro grupo normalmente é chamado de ‘grupo tratamento’ ou ‘grupo de tratamento’ e o outro, contr ao qual o tratamento (ou intervenção) é comparado, chamam ‘grupo controle’. Neste exemplo específico, temos um ‘grupo controle placebo’. Para garantir a extrapolabilidade e consistência dos resultados, os pesquisadores também aleatorizaram (ou ‘casualizaram’ ou ‘randomizaram’) o processo de alocação do tratamento e do placebo – ou seja, os cientistas escolhem ao acaso que individuo tomará o placebo e qual receberá o tratamento (ou intervenção) sendo investigado. Procede-se desta forma para evitar que alguma forma de viés ou tendenciosidade interfira no processo, como, por exemplo, a possibilidade de a maioria dos sujeitos experimentais com o melhor prognóstico ou com sintomas mais graves serem alocados em sua maioria em um grupo e não no outro. Muitas vezes, além da alocação aleatória, ‘pareiam-se os sujeitos experimentais’. Essa é uma forma de os pesquisadores certificarem-se que existam indivíduos com as mesmas características nos dois grupos (idade, peso, sexo, status de fumante etc) de modo que sempre um do par receba o tratamento e outro receba o placebo. Desta maneira, procura-se garantir que quaisquer diferenças entre os dois grupos, caso sejam encontradas, possam muito mais plausivelmente serem atribuídas ao tratamento (ou ausência dele) e não há outra fonte de erro sistemático.

Em testes clínicos geralmente busca-se (pelo menos sempre que possível) ‘mascarar’ ou ‘cegar’ os sujeitos experimentais e pesquisadores ao que está sendo administrado e medido. O que se pretende com esses procedimentos é que (por exemplo, ao aplicar o tratamento ou placebo e medir as alterações de pressão), como os pacientes e pesquisadores não saberiam que indivíduo recebeu o quê), não haveria qualquer tentação consciente ou inconsciente de um pesquisador medir de novo ou dar mais ou menos atenção a um paciente ou, um paciente ficar mais ou menos angustiado e obcecado com algum sintoma ou sinal, influenciando na sua medida. Caso essas possibilidades não fossem controladas teríamos mais uma fonte de erro no processo e isso tornaria nossas conclusões ainda mais incertas. Esse procedimento é chamado de ‘protocolo duplo-cego’.

Na pesquisa clínica, o ‘padrão ouro’ são os ‘Ensaios clínicos aleatorizados duplo-cegos com grupo placebo’. Eles sintetizam a ideia de um teste experimental justo. Entretanto, tão importante como o protocolo em si é o seu planejamento prévio e os cuidados tomados com sua condução em cada uma de suas várias etapas, como durante a escolha do método de aleatorização e a execução de procedimentos como o ‘cegamento’ de sujeitos experimentais e pesquisadores ou medidas das variáveis.

Todos esses procedimentos são implementados para garantir minimamente a legitimidade das conclusões e são complementares aos procedimentos estatísticos per se que visam controlar os chamados ‘erros aleatórios’, que resultam do fato de nenhum dois grupos (em relação um ao outro) ou amostras (em relação a uma população) serem perfeitamente iguais.

Agora voltemos ao valor-p. Ao analisar um experimento como o sugerido nos parágrafos anteriores, o que normalmente se deseja saber é se os dados obtidos sustentam a hipótese de que o fármaco é eficaz para a condição estudada. Em termos probabilísticos, isso seria a grosso modo equivalente a querer saber qual a probabilidade de que a Hipótese do Fármaco Funcionar (HFF) dado as eventuais diferenças encontradas entre os dois grupos (Dados) seja verdadeira. Perceba que temos aqui também uma probabilidade condicional que pode ser representada como indicado abaixo:

Pr (HFF| Dados Observados)

Mas como já vimos, o que o valor-p indicaria seria algo bem diferente – leia-se, a probabilidade de obtermos aquela diferença (ou diferenças ainda mais extremas. Lembre-se, o valor-p é uma probabilidade cumulativa e que se refere a alguns resultados hipotéticos) caso a hipótese de nulidade fosse verdadeira. Veja que, além de não testarmos HFF e sim H0, caso a hipótese de nulidade fosse que a pressão arterial entre os dois grupos não deveria ser substancialmente diferente, poderíamos ter um resultado, mas caso a hipótese de nulidade fosse que a diferença entre os dois grupos não deveria passar de um dado valor para mais, poderíamos ter outra probabilidade.

Desta maneira, a rejeição ou não de H0 (ou HM) e a conclusão de que esse resultado de alguma forma sustenta a hipótese alternativa (que, neste caso, esperaríamos ser HFF) não pode ser considerada uma inferência direta deste processo. Mesmo na abordagem Neyman-Pearson, na qual uma hipótese alternativa é explicitada, sua aceitação, ao rejeita-se a HM, é convencional e depende de outras questões.

Sendo assim, a conclusão final de que a tal diferença seria devida a uma causa específica (como ação do fármaco testado, por exemplo) não é produto exclusivo do teste estatístico, mas sim de um conjunto de outros fatores e considerações internas com de outros fatores externos. Entre os fatores internos estão os demais controles presentes no estudo, a maneira como o estudo foi conduzido, a confiabilidade dos procedimentos de aleatorização, cegamento etc. Já entre os fatores externos estão a própria plausibilidade inicial dessa hipótese de efeito, por exemplo, oriunda de evidências prévias encontradas em outros tipos de estudos (com estudos in vitro e in vivo em animais), bem como de conhecimentos teóricos específicos mais fundamentais (como os advindos da química orgânica, bioquímica, biofísica, fisiologia, farmacologia etc), além da existência de eventuais estudos independentes (de preferência bem planejados e bem conduzidos) que reproduzam estes resultados [3].

Os valores-p também não nos dizem nada sobre a relevância ou importância destes resultados, ou seja, sobre a chamada ‘significância científica’. Existem métricas para isso, como o ‘tamanho do efeito’ (ou medidas como o ‘número de pacientes a tratar’, no caso da pesquisa clínica) que podem ser expressas em porcentagens ou desvios padrões, por exemplo, mas, muitas vezes, a tal ‘significância científica’ tem que ser aferida caso a caso a partir de um exame mais minucioso das evidências e de múltiplas considerações. Um dos problemas em concentrarmo-nos somente nos valores-p é que quanto maior a amostra utilizada, em tese, menores são as diferenças que podem ser identificadas como estatisticamente significativas e, como raramente duas amostras serão idênticas ao idealmente esperado, pelo menos para estudos únicos, a significância estatística pode acabar perdendo qualquer significado real [4]. Parte da crise de reprodutibilidade e replicabilidade decorre dos efeitos do excesso de confiança nos valores-p e na ideia de significância estatística.

Em um comentário na revista Nature de 2019 Valentin Amrhein, Sander Greenland e Blake McShane afirmam:

Infelizmente, a falsa crença de que cruzar o limiar da significância estatística é suficiente para mostrar que um resultado é “real” levou cientistas e editores de periódicos a privilegiar esses resultados, distorcendo assim a literatura. As estimativas estatisticamente significativas são enviesadas para cima em magnitude e potencialmente em um grande grau, enquanto as estimativas estatisticamente não significativas são enviesadas para baixo em magnitude. Consequentemente, qualquer discussão que enfoque as estimativas escolhidas por sua significância será enviesada. Além disso, o foco rígido na significância estatística incentiva os pesquisadores a escolher dados e métodos que gerem significância estatística para algum resultado desejado (ou simplesmente publicável), ou que gerem não significância estatística para um resultado indesejado, como potenciais efeitos colaterais de drogas – invalidando assim as conclusões.

Como ficamos então? Desmistificar o conceito de significância estatística (ou mesmo o abolirmos completamente como alguns cientistas tem cada mais mais sugerido, inclusive os autores da citação acima), além de explicar com mais precisão o que são os valores-p (e, especialmente, o que eles não são e o que medem de verdade) são medidas essenciais. Porém, é preciso mais. É fundamental também enfatizar a importância do planejamento prévio dos estudos (especialmente o cálculo prévio de potência estatística para decidir de modo informado o tamanho da amostra), bem como estimular os cientistas a informarem os tamanhos do efeitos e, sempre que possível, utilizarem intervalos de confiança, além de deixar bem claro se seus estudos são exploratórios iniciais ou estudos já de validação de estudos preliminares anteriores.

Existem também muitos procedimentos alternativos que prescindem de (ou corrigem para) o uso do valor-p, tanto dentro da própria abordagem frequencialista como os que abraçam a abordagem Bayesiana (“Ciência e inferência. Parte III: O bom e velho reverendo”). O problema é que todas essas alternativas são bem mais complicadas e, apesar de estratégias de implementação mais simples já estarem sendo desenvolvidas, ainda assim, todas demandam uma substancial mudança de cultura acadêmica.

Várias dessas mudanças envolvem alterações na formação dos pesquisidores. Por exemplo, é preciso melhorar o treinamento de alunos de graduação e pós em estatística, delineamento de pesquisa e análise de dados. É preciso que os cursos sejam não só ampliados como modificados. Também é muito importante que os próprios departamentos das universidades e institutos de pesquisa façam sua parte. Uma das recomendações é que essas instituições contratem especialistas em estatística para revisar propostas e estudos, de preferência antes de sua execução, de modo darem o devido suporte aos pesquisadores já estabelecidos e treinamento e aconselhamento aos em formação.

Por fim, também se fazem necessárias mudanças nas próprias políticas editoriais e de revisão por pares das revistas científicas. Seria muito bom se as revistas fornecessem aos revisores não-estatísticos diretrizes mais rígidas e detalhadas (elaboradas por especialistas em estatística) de como proceder para avaliar a seção de métodos dos artigos, sendo revisados, destinada a análise estatística e planejamento do estudo. Além disso, seria muito importante que as editoras mantivessem um corpo habilitado de revisores ou editores especializados em estatística, delineamento de pesquisa e análise de dados. Este corpo deveria ser acionado (pelo menos) toda vez que novas abordagens, métodos ou testes estatísticos diferentes dos convencionalmente empregados fossem utilizados ou quando resultados muito impressionares aparecessem e que os revisores de conteúdos tradicionais não se sentissem habilitados a analisá-los. Esses mesmos profissionais de estatística, de tempos em tempos, também poderiam escolher alguns artigos de maneira aleatória que estivessem passando pelo processo de revisão para refazerem alguns dos cálculos e testes estatísticos para confirmar que os resultados foram adequadamente tratados, o que poderia servir como filtro extra para os erros que costumam ocorrer. Como tudo isso custa dinheiro, leva tempo e, potencialmente, diminui o número de trabalhos publicados (indo na contramão das tendências da pesquisa científica moderna), essas ações ainda demorarão muito tempo a serem incorporadas a prática acadêmico-científica. Mas as propostas e a consciência de sua necessidade já estão por aí.

Nas minhas próximas postagens voltarei ao tema, concentrando-me em uma alternativa ao uso de valores-p e do conceito de significância estatística proposta pelo bioestatístico David Colquhoun, o ‘Risco de Falso Positivo’. Essa medida se propõe a indicar com que frequência que alguém estará errado caso obtenha um resultado positivo em um estudo específico e assuma que ele é um efeito real e não meramente um produto do acaso. Esse tipo de medida é exatamente aquilo que muitas pessoas acreditam ser dado pelo valor-p , mas que, como já vimos, não é o caso.

1 – Embora eu não seja e nunca tenha sido um especialista em pesquisa experimental e muito menos um estatístico, desde a pós-graduação tenho um enorme interesse por essas duas áreas. Nas últimas três décadas, mesmo depois que me afastei do meio acadêmico, fiz disciplinas, recebi treinamento e adquiri alguma experiência com esses assuntos. Porém, nada disso me impede de vacilar e, eventualmente, cometer erros ao descrever o que diabos seria o tal ‘valor-p’ e o que é a famigerada ‘significância estatística’. Esse e outros posts são também uma forma de corrigir esta minha deficiência. Essa nem é a primeira vez que toco nesse tema (“Cuidado com os valores-p”, “Ciência e inferência. Parte I: A dúvida de Hume e a solução de Popper.”, “Ciência e inferência. Parte II: Popper e a tese do holismo.”, “Ciência e inferência. Parte III: O bom e velho reverendo”, “Ciência e Inferência Parte IV: Probabilidades e probabilidades”). Infelizmente, a maioria das figuras dos artigos da série “Ciência e Inferência” não estão mais disponíveis pois estavam linkadas ao site do Bule Voador. O texto ainda pode ser acessado aqui no blog nos links acima, e muitas das explicações e considerações podem ser compreendidas com um pouco mais de esforço sem as figuras, mas, claro, as postagens acabaram por serem comprometidas. Essa é outra razão por que pretendo voltar a esses temas e expandi-los em novas postagens nos próximos meses.

2 – Na realidade, embora a H0 de Fisher e a HM (ou H0) de Neyman-Pearson tenham semelhanças superficiais, elas não são idênticas. Enquanto a versão de Neyman-Pearson (HM) deve ser considerada desde o início, ainda na fase de planejamento dos estudos, a H0 de Fisher raramente é explicitada nesta fase. Além disso, a HM é projetada para incorporar qualquer valor abaixo do tamanho do efeito mínimo esperado, o que não ocorre na abordagem de Fisher; além de ser apenas uma de duas explicações concorrentes para os resultados da pesquisa [Veja o artigo de Jose D. Perezgonzalez referido na seção para saber mais.]

3 – Esta é outra questão importante que já levantei em outras postagens mais antigas. A escolha do Alfa (o ponto de corte) e mesmo do tamanho de efeito suposto devem, sim, serem ajustados, levando-se em conta a plausibilidade da hipótese e as evidências prévias sobre o tópico investigado. Alegações extraordinárias demandam um ônus muito maior do que alegações mais triviais e apoiadas por outras evidências não controversas. Porém, em contrapartida, resultados negativos (ou seja, não ‘estatisticamente significantes’) devem, sim, serem considerados resultados dignos de interesse científico e, portanto, passíveis de publicação em um periódico acadêmico, especialmente caso contrariem as expectativas e tenham sido obtidos em estudos cuja amostra foi bem dimensionada e tenha sido todo bem executado. Esses são fatores muito mais apropriados para decidir se um artigo deveria ser ou não publicado. A originalidade do tema, a qualidade metodológica e da execução do trabalho, além de própria relevância científica são critérios muito melhores do que se os testes estatísticos indicaram um resultado significativo ou não. Além disso, volto a dizer, é tremendamente importante deixar claras as diferenças entre estudos preliminares (exploratórios) e estudos de validação, muitos dois quais deveriam ser inclusive pré-registrados com intuito de replicações futuras e para que possam ser incorporados em revisões sistemáticas e meta-análises de maneira apropriada. Por fim, é essencial incentivar replicações independentes de estudos maiores ou cujo resultados são muito controversos e deveria haver um incentivo por parte das revistas em realizá-los.

4 – Mesmo no caso de resultados negativos (isto é, aqueles cujas diferenças observadas entre grupos seriam ‘não estatisticamente significantes’), a possibilidade de falsos negativos também coloca os pesquisadores em risco de deixarem de fazer descobertas importantes, pois pode levá-los a ignorar resultados que apoiariam a existência de diferenças reais. O que acontece é que muitas vezes, mesmo um resultado não significativo, pode, ajudar a aumentar a confiança dos pesquisadores na existência de um efeito real, especialmente caso o tamanho dos efeitos e a direção dos mesmos sejam consistentes e replicáveis entre vários estudos. Ferramentas como as meta-análises podem ao permitir a agregação de vários pequenos estudos individuais auxiliar os pesquisadores a decidir se valeria ou não a pena insistir em uma hipótese em particular, indicando que talvez valesse a pena tentar testá-la em um estudo futuro mais amplo e mais bem controlado, planejado especificamente para esse fim.

Aconselho alguns vídeos do canal StatQuest with Josh Starmer nos quais conceitos como valor-p, testes estatísticos de hipóteses e potência estatística são explicados de maneira clara e lúdica:

Para saber mais:

- Amrhein, V., Greenland, S. & McShane, B. Scientists rise up against statistical significance (COMMENT 20 March 2019) Nature 567, 305-307. 2019 doi: https://doi.org/10.1038/d41586-019-00857-9

- Colquhoun, D. The problem with p-values It’s time for science to abandon the term ‘statistically significant’ | Aeon Essays. 11 October 2016. Retrieved February 18, 2021.

- Gigerenzer, G. Mindless statistics. The Journal of Socio-Economics, 33(5), 2004. 587–606. doi:10.1016/j.socec.2004.09.033.

- Denis, D. J. The modern hypothesis testing hybrid: R. A. Fisher’s fading influence. Journal de la société française de statistique, Tome 145 2004 no. 4, pp. 5-26.

- Doan, T. N, What can an Octopus tell us about the biggest debate in statistical theory? Towards Data Science Aug 15 2018. Retrieved February 27, 2021.

- Perezgonzalez, J. D. Fisher, Neyman-Pearson or NHST? A tutorial for teaching data testing Front. Psychol., 03 March 2015 Retrieved February 13, 2021. https://doi.org/10.3389/fpsyg.2015.00223

- Pernet C. Null hypothesis significance testing: a short tutorial [version 3; referees: 1 approved, 1 approved with reservations, 2 not approved] F1000Research 2016, 4 :621 doi: 10.12688/f1000research.6963.3.

- Robert, D. Demystifying the p-value. The Startup – Medium. Jun 26 2020. Retrieved February 13, 2021.

- Szucs D, Ioannidis JPA. When Null Hypothesis Significance Testing Is Unsuitable for Research: A Reassessment. Front Hum Neurosci. 2017;11:390. Published 2017 Aug 3. doi:10.3389/fnhum.2017.00390

experiências dentro de uma perspectiva científica convencional e filosoficamente naturalista.

experiências dentro de uma perspectiva científica convencional e filosoficamente naturalista.  cirúrgicos, realmente mostram.

cirúrgicos, realmente mostram. problemas com a interpretação das evidencias clínicas e instrumentais, frequentemente, empregadas pelos sobrevivencialistas para endossar sua posição.

problemas com a interpretação das evidencias clínicas e instrumentais, frequentemente, empregadas pelos sobrevivencialistas para endossar sua posição.

Evolucionismo

Evolucionismo